SFR Judge

SFR-Judge 是 Salesforce AI Research 推出的一系列评估模型,旨在通过人工智能技术加速大型语言模型(LLMs)的评估和微调过程。这些模型能够执行多种评估任务,包括成对比较、单项评分和二元分类,同时提供解释,避免黑箱问题。SFR-Judge 在多个基准测试中表现优异,证明了其在评估模型输出和指导微调方面的有效性。

AI模型评估工具

50.8K

1X World Model

1X 世界模型是一种机器学习程序,能够模拟世界如何响应机器人的行为。它基于视频生成和自动驾驶汽车世界模型的技术进步,为机器人提供了一个虚拟模拟器,能够预测未来的场景并评估机器人策略。这个模型不仅能够处理复杂的对象交互,如刚体、掉落物体的影响、部分可观察性、可变形物体和铰接物体,还能够在不断变化的环境中进行评估,这对于机器人技术的发展至关重要。

模型训练与部署虚拟模拟

54.4K

优质新品

Weavel

Weavel是一个AI提示工程师,它通过追踪、数据集管理、批量测试和评估等功能,帮助用户优化大型语言模型(LLM)的应用。Weavel与Weavel SDK结合使用,能够自动记录并添加LLM生成的数据到您的数据集中,实现无缝集成和针对特定用例的持续改进。此外,Weavel能够自动生成评估代码,并使用LLM作为复杂任务的公正裁判,简化评估流程,确保准确、细致的性能指标。

开发与工具数据集管理

52.4K

优质新品

Ragelo

RAGElo是一个工具集,使用Elo评分系统帮助选择最佳的基于检索增强生成(RAG)的大型语言模型(LLM)代理。随着生成性LLM在生产中的原型设计和整合变得更加容易,评估仍然是解决方案中最具有挑战性的部分。RAGElo通过比较不同RAG管道和提示对多个问题的答案,计算不同设置的排名,提供了一个良好的概览,了解哪些设置有效,哪些无效。

AI模型RAG

60.2K

优质新品

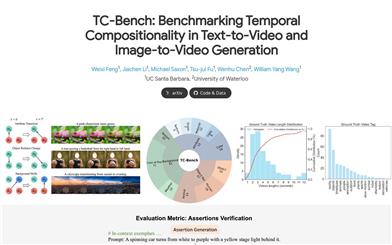

TC Bench

TC-Bench是一个专门用于评估视频生成模型的时间组合性的工具。它通过精心设计的文本提示、相应的真实视频以及强大的评估指标来衡量视频生成模型在不同时间点上新概念的出现及其关系转换的能力。TC-Bench不仅适用于文本条件模型,也适用于图像条件模型,能够进行生成性帧插值。该工具的开发旨在推动视频生成技术的发展,提高生成视频的质量和一致性。

AI视频生成评估工具

58.0K

Prometheus Eval

Prometheus-Eval 是一个用于评估大型语言模型(LLM)在生成任务中表现的开源工具集。它提供了一个简单的接口,使用 Prometheus 模型来评估指令和响应对。Prometheus 2 模型支持直接评估(绝对评分)和成对排名(相对评分),能够模拟人类判断和专有的基于语言模型的评估,解决了公平性、可控性和可负担性的问题。

AI模型语言模型

56.0K

Multi Modal Large Language Models

该工具旨在通过对最新专有和开源MLLMs进行定性研究,从文本、代码、图像和视频四个模态的角度,评估其泛化能力、可信度和因果推理能力,以提高MLLMs的透明度。我们相信这些属性是定义MLLMs可靠性的几个代表性因素,支持各种下游应用。具体而言,我们评估了闭源的GPT-4和Gemini以及6个开源LLMs和MLLMs。总体上,我们评估了230个手动设计的案例,定性结果总结为12个分数(即4个模态乘以3个属性)。总共,我们揭示了14个实证发现,有助于了解专有和开源MLLMs的能力和局限性,以更可靠地支持多模态下游应用。

AI模型评测评估工具

58.2K

Unitxt

Unitxt是一款创新的库,专为生成式语言模型量身定制,用于定制文本数据准备和评估。Unitxt与HuggingFace和LM-eval-harness等常用库进行原生集成,并将处理流程拆分为模块化组件,实现了易定制和共享。这些组件包括模型特定格式、任务提示等全面的数据集处理定义。Unitxt-Catalog集中了这些组件,促进了现代文本数据工作流中的协作和探索。除了是一款工具,Unitxt还是一个社区驱动的平台,赋予用户协作构建、分享和推进他们的数据流水线的能力。

AI开发助手生成式AI

54.1K

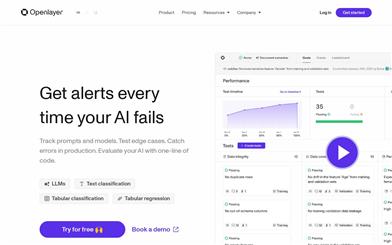

Openlayer

Openlayer是一个评估工具,适用于您的开发和生产流程,帮助您自信地发布高质量的模型。它提供强大的测试、评估和可观察性,无需猜测您的提示是否足够好。支持LLMs、文本分类、表格分类、表格回归等功能。通过实时通知让您在AI模型失败时获得通知,让您自信地发布。

模型训练与部署模型测试

51.3K

精选AI产品推荐

中文精选

Nocode

NoCode 是一款无需编程经验的平台,允许用户通过自然语言描述创意并快速生成应用,旨在降低开发门槛,让更多人能实现他们的创意。该平台提供实时预览和一键部署功能,非常适合非技术背景的用户,帮助他们将想法转化为现实。

开发平台应用开发

168.9K

优质新品

Listenhub

ListenHub 是一款轻量级的 AI 播客生成工具,支持中文和英语,基于前沿 AI 技术,能够快速生成用户感兴趣的播客内容。其主要优点包括自然对话和超真实人声效果,使得用户能够随时随地享受高品质的听觉体验。ListenHub 不仅提升了内容生成的速度,还兼容移动端,便于用户在不同场合使用。产品定位为高效的信息获取工具,适合广泛的听众需求。

音频生成AI

120.9K

国外精选

Lovart

Lovart 是一款革命性的 AI 设计代理,能够将创意提示转化为艺术作品,支持从故事板到品牌视觉的多种设计需求。其重要性在于打破传统设计流程,节省时间并提升创意灵感。Lovart 当前处于测试阶段,用户可加入等候名单,随时体验设计的乐趣。

AI设计工具创意工具

138.0K

Fastvlm

FastVLM 是一种高效的视觉编码模型,专为视觉语言模型设计。它通过创新的 FastViTHD 混合视觉编码器,减少了高分辨率图像的编码时间和输出的 token 数量,使得模型在速度和精度上表现出色。FastVLM 的主要定位是为开发者提供强大的视觉语言处理能力,适用于各种应用场景,尤其在需要快速响应的移动设备上表现优异。

AI模型图像处理

102.1K

国外精选

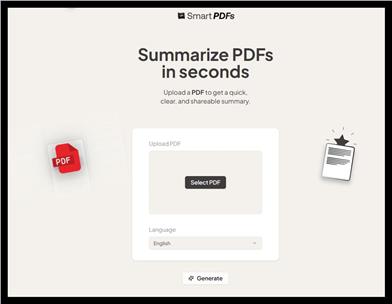

Smart PDFs

Smart PDFs 是一个在线工具,利用 AI 技术快速分析 PDF 文档,并生成简明扼要的总结。它适合需要快速获取文档要点的用户,如学生、研究人员和商务人士。该工具使用 Llama 3.3 模型,支持多种语言,是提高工作效率的理想选择,完全免费使用。

文章摘要AI

69.3K

Keysync

KeySync 是一个针对高分辨率视频的无泄漏唇同步框架。它解决了传统唇同步技术中的时间一致性问题,同时通过巧妙的遮罩策略处理表情泄漏和面部遮挡。KeySync 的优越性体现在其在唇重建和跨同步方面的先进成果,适用于自动配音等实际应用场景。

视频编辑视频处理

92.2K

Anyvoice

AnyVoice是一款领先的AI声音生成器,采用先进的深度学习模型,将文本转换为与人类无法区分的自然语音。其主要优点包括超真实的声音效果、多语言支持、快速生成能力以及语音定制功能。该产品适用于多种场景,如内容创作、教育、商业和娱乐制作等,旨在为用户提供高效、便捷的语音生成解决方案。目前产品提供免费试用,适合不同层次的用户。

音频生成文本转语音

663.8K

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型图像生成

8.0M

智启未来,您的人工智能解决方案智库

简体中文