LLM Compiler 13b

简介 :

Meta Large Language Model Compiler (LLM Compiler-13b) 是基于Code Llama构建的,专注于代码优化和编译器推理的先进大型语言模型。它在编译器优化任务上展现出比现有公开可用的大型语言模型更强的理解能力,能够完美模拟编译器输出20%的时间。LLM Compiler提供了两种模型尺寸:7B和13B参数,针对不同的服务和延迟需求进行了训练。该模型是免费的,适用于研究和商业用途,旨在支持编译器研究人员和工程师,并激发创新工具的开发。

需求人群 :

LLM Compiler的目标受众是编译器研究人员、工程师以及希望提高代码效率和减小程序体积的开发者。该技术能够帮助他们通过自动化的方式进行代码优化,减少手动优化的工作量,同时提高编译器输出的准确性和效率。

使用场景

使用LLM Compiler对大型软件项目进行代码优化,减少最终程序的体积。

在编译器开发过程中,利用LLM Compiler预测不同优化策略对代码性能的影响。

在教育领域,作为教学工具,帮助学生理解编译器优化的原理和效果。

产品特色

预测LLVM优化对代码大小的影响

生成最小化代码大小的优化传递列表

从x86_64或ARM汇编代码生成LLVM IR

在编译器优化任务中实现高精度的代码仿真

提供7B和13B参数的模型以满足不同延迟需求

通过深度学习优化代码,提高程序效率和减小程序大小

使用教程

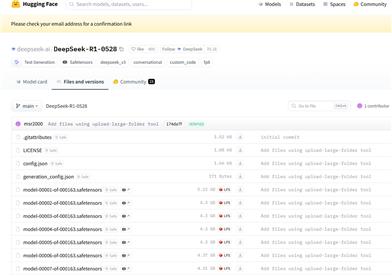

安装必要的库和依赖,例如transformers。

从Hugging Face下载所需的LLM Compiler模型。

使用AutoTokenizer从预训练模型中加载分词器。

设置transformers.pipeline进行文本生成,配置适当的参数。

通过pipeline输入待优化的代码片段,获取模型生成的优化建议。

根据模型输出的结果,对代码进行调整和优化。

对优化后的代码进行测试,确保优化效果符合预期。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型多模态

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型图像生成

8.0M

智启未来,您的人工智能解决方案智库

简体中文