Modernbert Large

ModernBERT-large是一个现代化的双向编码器Transformer模型(BERT风格),在2万亿个英文和代码数据上预训练,具有长达8192个token的原生上下文长度。该模型采用了最新的架构改进,如旋转位置嵌入(RoPE)以支持长上下文,局部-全局交替注意力以提高长输入的效率,以及无填充和Flash Attention以提高推理效率。ModernBERT-long适合处理需要处理长文档的任务,如检索、分类和大型语料库中的语义搜索。模型训练数据主要是英文和代码,因此可能在其他语言上的表现会较低。

AI搜索Transformer

56.6K

Qwen2.5 Coder 1.5B Instruct GPTQ Int8

Qwen2.5-Coder是Qwen大型语言模型的最新系列,专注于代码生成、代码推理和代码修复。基于强大的Qwen2.5,该模型在训练中使用了5.5万亿的源代码、文本代码关联、合成数据等,使其成为当前开源代码语言模型中的佼佼者。该模型不仅在编程能力上有所增强,还保持了在数学和通用能力方面的优势。

代码推理

48.3K

Qwen2.5 Coder 3B Instruct GPTQ Int8

Qwen2.5-Coder-3B-Instruct-GPTQ-Int8是Qwen2.5-Coder系列中的一种大型语言模型,专门针对代码生成、代码推理和代码修复进行了优化。该模型基于Qwen2.5,训练数据包括源代码、文本代码关联、合成数据等,达到5.5万亿个训练令牌。Qwen2.5-Coder-32B已成为当前最先进的开源代码大型语言模型,其编码能力与GPT-4o相匹配。该模型还为现实世界中的应用提供了更全面的基础,如代码代理,不仅增强了编码能力,还保持了在数学和通用能力方面的优势。

代码推理

52.7K

优质新品

AI21 Jamba 1.5 Large

AI21 Jamba 1.5系列模型是市场上最强大的长上下文模型之一,提供比同类领先模型快2.5倍的推理速度。这些模型展示了卓越的长上下文处理能力、速度和质量,是首次成功将非Transformer模型扩展到市场领先模型的质量和强度。

AI模型长上下文

52.7K

Gemini Pro

Gemini Pro是DeepMind推出的一款高性能多模态AI模型,专为广泛的任务设计,具有高达两百万token的长上下文窗口,能够处理大规模文档、代码、音频和视频等。它在多个基准测试中表现出色,包括代码生成、数学问题解决和多语言翻译等。

AI模型多模态

69.8K

Longva

LongVA是一个能够处理超过2000帧或超过200K视觉标记的长上下文转换模型。它在Video-MME中的表现在7B模型中处于领先地位。该模型基于CUDA 11.8和A100-SXM-80G进行了测试,并且可以通过Hugging Face平台进行快速启动和使用。

AI模型视觉模型

59.9K

优质新品

Samba

Samba是一个简单而强大的混合模型,具有无限的上下文长度。它的架构非常简单:Samba = Mamba + MLP + 滑动窗口注意力 + 层级MLP堆叠。Samba-3.8B模型在Phi3数据集上训练了3.2万亿个token,主要基准测试(例如MMLU、GSM8K和HumanEval)上的表现大大超过了Phi3-mini。Samba还可以通过最少的指令调整实现完美的长上下文检索能力,同时保持与序列长度的线性复杂度。这使得Samba-3.8B-instruct在下游任务(如长上下文摘要)上表现出色。

AI模型机器学习

58.0K

中文精选

Qwen1.5

Qwen1.5是Qwen系列的下一个版本,提供了基础和聊天模型的开源版本,覆盖了0.5B到72B的多个规模。支持多语言,长上下文,对齐人类偏好,并在基本能力、聊天性能、多语言理解等方面取得显著进展。

AI模型多语言

638.1K

国外精选

Flash Decoding

Flash-Decoding是一种针对长上下文推理的技术,可以显著加速推理中的注意力机制,从而使生成速度提高8倍。该技术通过并行加载键和值,然后分别重新缩放和组合结果来维护正确的注意力输出,从而实现了更快的推理速度。Flash-Decoding适用于大型语言模型,可以处理长文档、长对话或整个代码库等长上下文。Flash-Decoding已经在FlashAttention包和xFormers中提供,可以自动选择Flash-Decoding或FlashAttention方法,也可以使用高效的Triton内核。

AI模型注意力机制

101.6K

精选AI产品推荐

中文精选

Nocode

NoCode 是一款无需编程经验的平台,允许用户通过自然语言描述创意并快速生成应用,旨在降低开发门槛,让更多人能实现他们的创意。该平台提供实时预览和一键部署功能,非常适合非技术背景的用户,帮助他们将想法转化为现实。

开发平台应用开发

168.9K

优质新品

Listenhub

ListenHub 是一款轻量级的 AI 播客生成工具,支持中文和英语,基于前沿 AI 技术,能够快速生成用户感兴趣的播客内容。其主要优点包括自然对话和超真实人声效果,使得用户能够随时随地享受高品质的听觉体验。ListenHub 不仅提升了内容生成的速度,还兼容移动端,便于用户在不同场合使用。产品定位为高效的信息获取工具,适合广泛的听众需求。

音频生成AI

120.9K

国外精选

Lovart

Lovart 是一款革命性的 AI 设计代理,能够将创意提示转化为艺术作品,支持从故事板到品牌视觉的多种设计需求。其重要性在于打破传统设计流程,节省时间并提升创意灵感。Lovart 当前处于测试阶段,用户可加入等候名单,随时体验设计的乐趣。

AI设计工具创意工具

138.0K

Fastvlm

FastVLM 是一种高效的视觉编码模型,专为视觉语言模型设计。它通过创新的 FastViTHD 混合视觉编码器,减少了高分辨率图像的编码时间和输出的 token 数量,使得模型在速度和精度上表现出色。FastVLM 的主要定位是为开发者提供强大的视觉语言处理能力,适用于各种应用场景,尤其在需要快速响应的移动设备上表现优异。

AI模型图像处理

102.4K

国外精选

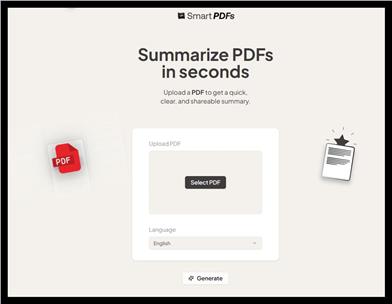

Smart PDFs

Smart PDFs 是一个在线工具,利用 AI 技术快速分析 PDF 文档,并生成简明扼要的总结。它适合需要快速获取文档要点的用户,如学生、研究人员和商务人士。该工具使用 Llama 3.3 模型,支持多种语言,是提高工作效率的理想选择,完全免费使用。

文章摘要AI

69.3K

Keysync

KeySync 是一个针对高分辨率视频的无泄漏唇同步框架。它解决了传统唇同步技术中的时间一致性问题,同时通过巧妙的遮罩策略处理表情泄漏和面部遮挡。KeySync 的优越性体现在其在唇重建和跨同步方面的先进成果,适用于自动配音等实际应用场景。

视频编辑视频处理

92.5K

Anyvoice

AnyVoice是一款领先的AI声音生成器,采用先进的深度学习模型,将文本转换为与人类无法区分的自然语音。其主要优点包括超真实的声音效果、多语言支持、快速生成能力以及语音定制功能。该产品适用于多种场景,如内容创作、教育、商业和娱乐制作等,旨在为用户提供高效、便捷的语音生成解决方案。目前产品提供免费试用,适合不同层次的用户。

音频生成文本转语音

664.1K

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型图像生成

8.0M

智启未来,您的人工智能解决方案智库

简体中文