MIDI

简介 :

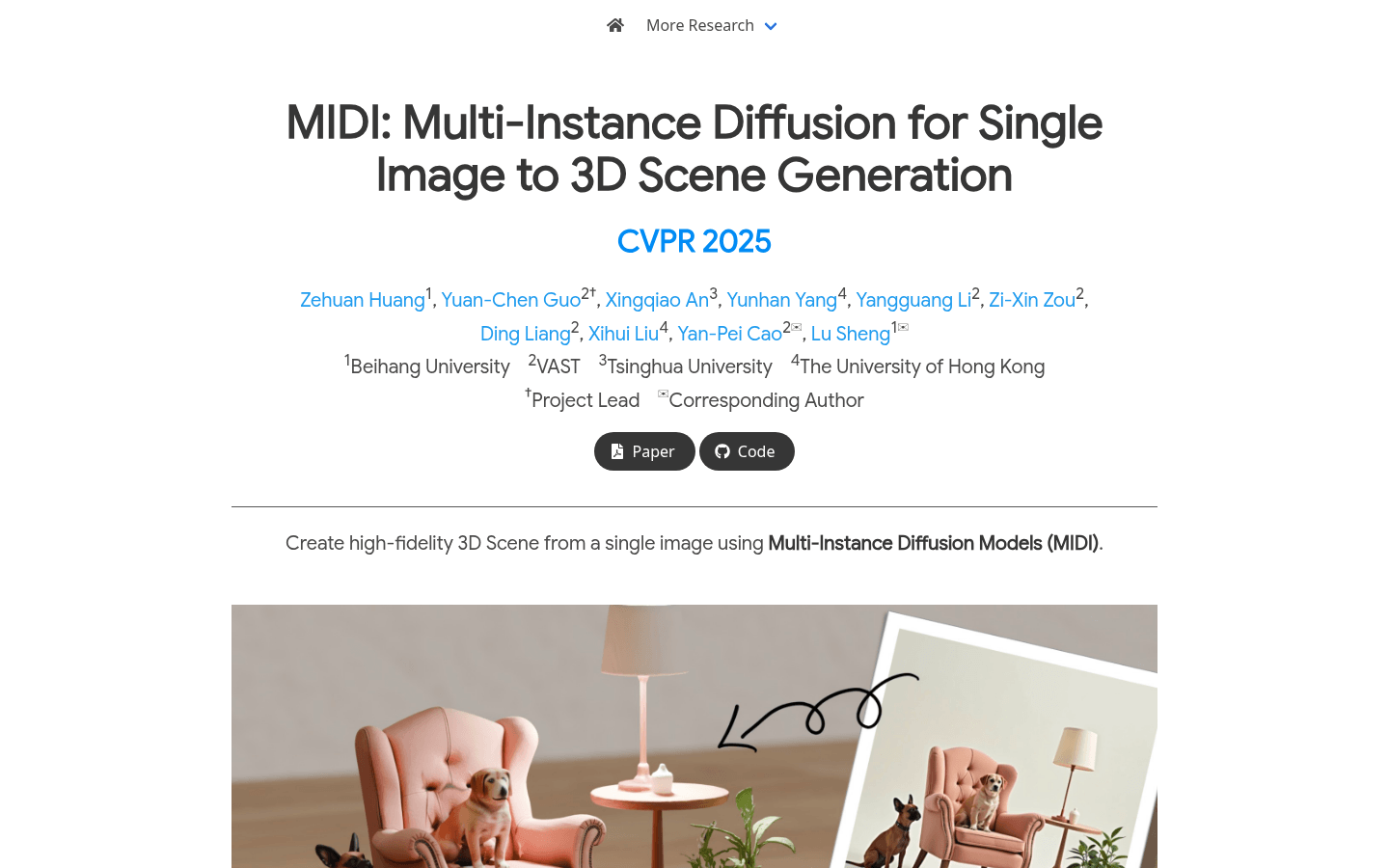

MIDI是一种创新的图像到3D场景生成技术,它利用多实例扩散模型,能够从单张图像中直接生成具有准确空间关系的多个3D实例。该技术的核心在于其多实例注意力机制,能够有效捕捉物体间的交互和空间一致性,无需复杂的多步骤处理。MIDI在图像到场景生成领域表现出色,适用于合成数据、真实场景数据以及由文本到图像扩散模型生成的风格化场景图像。其主要优点包括高效性、高保真度和强大的泛化能力。

需求人群 :

该产品主要面向计算机视觉、3D建模和图形学领域的研究者和开发者,以及对从单张图像生成3D场景感兴趣的行业从业者。它为需要高效、高质量3D场景生成的用户提供了一种创新的解决方案,适用于学术研究、内容创作、虚拟现实和游戏开发等领域。

使用场景

在学术研究中,研究人员可以利用MIDI生成3D场景,用于验证新的算法或模型。

在游戏开发中,开发者可以快速从概念图像生成3D场景,加速游戏世界的构建。

在虚拟现实应用中,MIDI可以将用户提供的图像转化为沉浸式的3D场景,增强用户体验。

产品特色

从单张图像生成多个3D实例,支持场景的直接组合。

采用多实例注意力机制,捕捉物体间交互和空间一致性。

利用部分物体图像和全局场景上下文作为输入,直接建模物体补全。

通过有限的场景级数据监督3D实例间的交互,同时使用单物体数据进行正则化。

支持多种数据类型,包括合成数据、真实场景数据和风格化场景图像。

生成的3D场景纹理可通过MV-Adapter进一步优化。

训练和生成过程高效,总处理时间仅需40秒。

模型代码开源,便于研究和开发人员使用和扩展。

使用教程

1. 访问MIDI项目页面,了解其功能和特点。

2. 下载并安装相关的代码库和依赖项。

3. 准备输入图像,可以是合成数据、真实场景图像或风格化图像。

4. 使用MIDI模型对输入图像进行处理,生成多个3D实例。

5. 将生成的3D实例组合成完整的3D场景。

6. 如果需要,可以使用MV-Adapter进一步优化场景纹理。

7. 根据需求对生成的3D场景进行后续处理或应用。

精选AI产品推荐

Face To Many

Face to Many 可以将一张面部照片转变成多种风格,包括 3D、表情符号、像素艺术、电子游戏风格、粘土动画或玩具风格。用户只需上传一张照片,然后选择想要转换的风格,即可轻松创建奇妙有趣的面部艺术作品。产品提供多种参数供用户自定义,包括降噪强度、提示强度、深度控制强度和 InstantID 强度。

图片生成AI

4.8M

国外精选

Luma AI

Luma AI是一家专注于AI的技术公司,通过其创新技术,用户可以利用手机快速生成所需的3D模型。公司由拥有丰富3D计算机视觉经验的团队成立,其技术基于Neural Radiance Fields,能够基于少量2D图像对3D场景进行建模。Dream Machine是一个AI模型,能够直接从文本和图像快速生成高质量的逼真视频。它是一个高度可扩展且高效的transformer模型,专门针对视频进行训练,能够生成物理上准确、一致且充满事件的镜头。Dream Machine是构建通用想象力引擎的第一步,现已对所有人开放。

3D建模DreamMachine

3.9M

智启未来,您的人工智能解决方案智库

简体中文