R1 Omni

简介 :

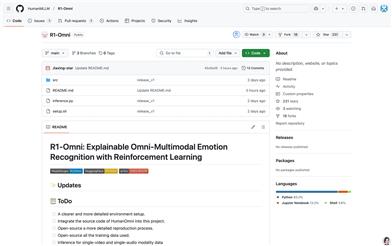

R1-Omni 是一个创新的多模态情绪识别模型,通过强化学习提升模型的推理能力和泛化能力。该模型基于 HumanOmni-0.5B 开发,专注于情绪识别任务,能够通过视觉和音频模态信息进行情绪分析。其主要优点包括强大的推理能力、显著提升的情绪识别性能以及在分布外数据上的出色表现。该模型适用于需要多模态理解的场景,如情感分析、智能客服等领域,具有重要的研究和应用价值。

需求人群 :

该模型适用于研究人员和开发者,特别是那些需要处理多模态情绪识别任务的团队。它可以帮助他们快速搭建和优化情绪识别系统,提升模型的性能和可解释性。同时,该模型也可用于教育领域,帮助学生和研究人员更好地理解强化学习在多模态任务中的应用。

使用场景

在智能客服系统中,通过分析客户语音和视频中的情绪,提供更精准的服务。

在心理健康应用中,通过分析用户的情绪表达,提供情绪疏导建议。

在视频内容审核中,自动检测视频中的负面情绪,辅助人工审核。

产品特色

结合强化学习提升情绪识别的推理能力

支持全模态输入(视频、音频)的情绪分析

提供详细的推理过程,增强模型的可解释性

在分布外数据上表现出色,具有强大的泛化能力

支持多种预训练模型的集成,如 Whisper 和 Siglip

提供详细的训练和推理代码,便于开发者复现和扩展

支持多种情绪数据集的训练和验证,如 DFEW 和 MAFW

提供模型的详细性能指标和可视化结果

使用教程

1. 下载并安装相关依赖,包括 PyTorch 和多模态模型(如 Whisper、Siglip)。

2. 克隆 R1-Omni 代码仓库,并按照 README 文件中的说明设置环境。

3. 下载预训练模型(如 HumanOmni-0.5B、R1-Omni 等)并配置路径。

4. 使用 inference.py 文件进行单视频或多模态输入的情绪推理。

5. 根据需要调整模型配置文件(config.json),以适配不同的输入数据。

6. 使用训练代码(如 train.py)进行模型的微调或自定义训练。

7. 通过可视化工具(如 wandb)查看模型训练和推理的结果。

8. 根据实际需求,将模型集成到具体的应用场景中,如智能客服或视频分析系统。

精选AI产品推荐

智启未来,您的人工智能解决方案智库

简体中文