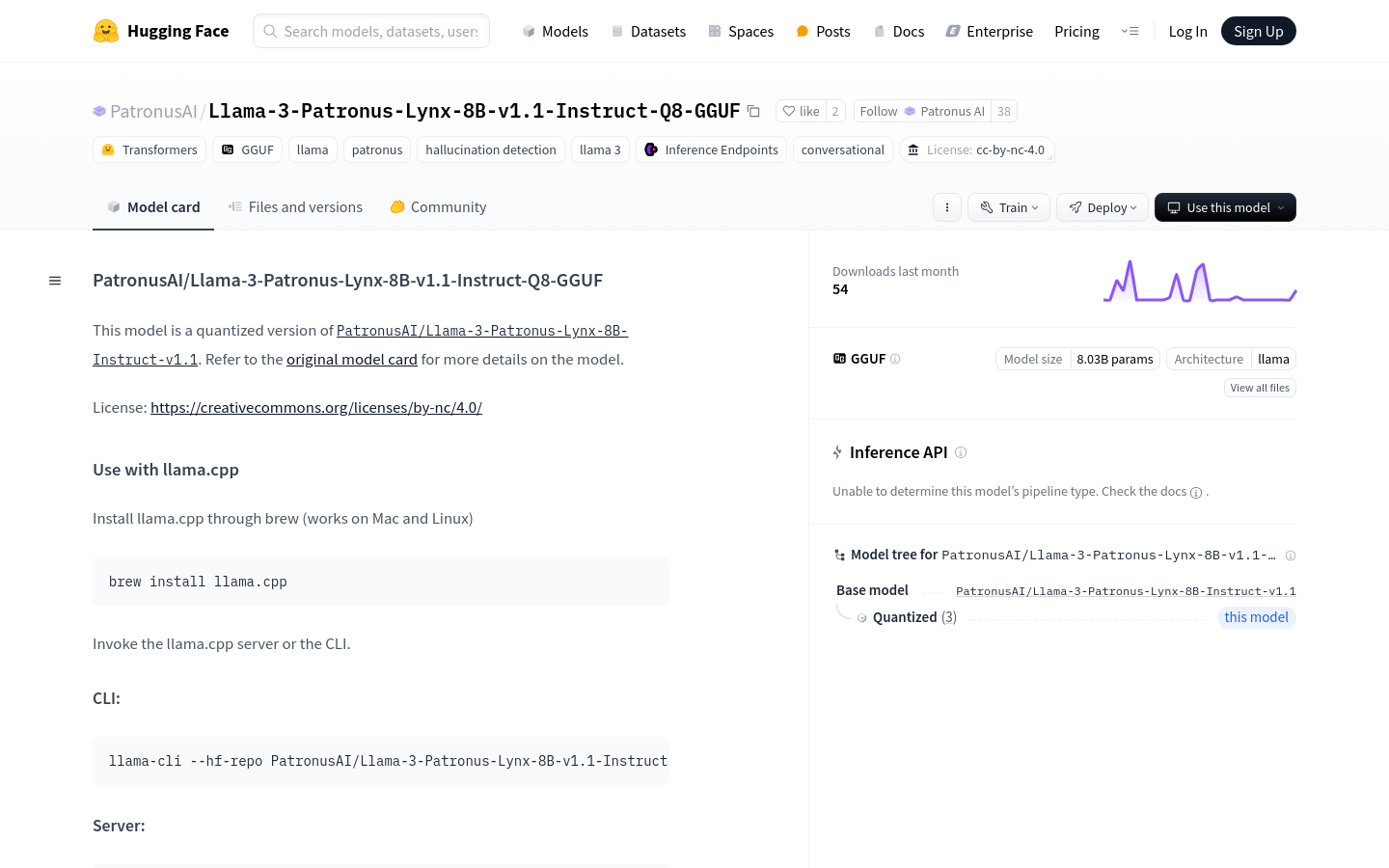

Llama 3 Patronus Lynx 8B V1.1 Instruct Q8 GGUF

简介 :

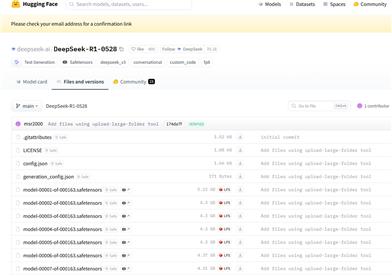

PatronusAI/Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF是一个基于Llama模型的量化版本,专为对话和幻觉检测设计。该模型使用了GGUF格式,拥有8.03亿参数,属于大型语言模型。它的重要性在于能够提供高质量的对话生成和幻觉检测能力,同时保持模型的高效运行。该模型是基于Transformers库和GGUF技术构建的,适用于需要高性能对话系统和内容生成的应用场景。

需求人群 :

目标受众为开发者、数据科学家以及需要构建高性能对话系统和内容生成平台的企业。该产品适合他们,因为它提供了一个强大的、可量化的模型,能够处理复杂的自然语言处理任务,同时保持高效的运行性能。

使用场景

案例1: 在线客服机器人,使用该模型生成自然语言回复,提高客户满意度。

案例2: 新闻内容审核系统,利用模型的幻觉检测功能过滤虚假新闻。

案例3: 教育平台,使用模型生成个性化的学习材料和对话练习。

产品特色

• 量化版本:模型经过量化处理,以提高运行效率。

• 对话生成:能够生成自然语言对话,适用于聊天机器人等应用。

• 幻觉检测:具备检测和过滤不真实信息的能力。

• 支持GGUF格式:使得模型能够被更广泛的工具和平台所使用。

• 8.03亿参数:拥有大量的参数,能够处理复杂的语言任务。

• 基于Transformers:利用了先进的Transformers技术,保证了模型的性能。

• 支持Inference Endpoints:可以直接通过API进行模型推理。

使用教程

1. 安装llama.cpp:通过brew安装llama.cpp,支持Mac和Linux系统。

2. 启动llama.cpp服务器或CLI:使用提供的命令行工具启动服务。

3. 运行推理:通过llama-cli或llama-server命令行工具运行模型推理。

4. 克隆llama.cpp:从GitHub克隆llama.cpp项目。

5. 构建llama.cpp:进入项目目录,使用LLAMA_CURL=1标志构建项目。

6. 执行主程序:运行构建好的llama-cli或llama-server进行模型推理。

精选AI产品推荐

智启未来,您的人工智能解决方案智库

简体中文