Smolvlm

简介 :

SmolVLM是一个小型但功能强大的视觉语言模型(VLM),拥有2B参数,以其较小的内存占用和高效性能在同类模型中处于领先地位。SmolVLM完全开源,包括所有模型检查点、VLM数据集、训练配方和工具均在Apache 2.0许可下发布。该模型适合在浏览器或边缘设备上进行本地部署,降低推理成本,并允许用户自定义。

需求人群 :

目标受众为需要在本地或边缘设备上部署视觉语言模型的开发者和企业,特别是那些对模型大小和推理成本敏感的用户。SmolVLM因其小巧、高效和开源的特性,特别适合资源受限的环境,如移动设备或小型服务器。

使用场景

使用SmolVLM为曼谷大皇宫提供旅行建议。

根据图表识别严重干旱发生的地区。

从发票中提取到期日和发票日期。

产品特色

支持多模态AI,能够在较小的本地设置中使用。

完全开源,允许商业使用和自定义部署。

内存占用小,适合在资源受限的设备上运行。

性能优异,提供了包括图像编码效率在内的多项基准测试结果。

支持视频分析任务,尤其是在计算资源有限的情况下。

与VLMEvalKit集成,方便在更多基准上进行评估。

可以通过Transformers库轻松加载和使用。

使用教程

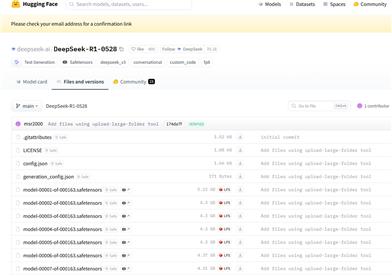

1. 访问SmolVLM的Hugging Face页面并下载所需的模型和处理器。

2. 使用Python和Transformers库加载模型和处理器。

3. 准备输入数据,包括图像和文本提示。

4. 通过处理器将输入数据格式化为模型可接受的格式。

5. 使用模型生成输出,如描述图像内容或回答与图像相关的问题。

6. 对生成的输出进行解码和后处理,以获取最终结果。

7. (可选)根据特定任务对SmolVLM进行微调,以提高性能。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型多模态

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型图像生成

8.0M

智启未来,您的人工智能解决方案智库

简体中文