Llama 3.1 Tulu 3 70B SFT

简介 :

Llama-3.1-Tulu-3-70B-SFT是Tülu3模型家族的一部分,专为现代后训练技术提供全面指南而设计。该模型不仅在聊天任务上表现出色,还在MATH、GSM8K和IFEval等多种任务上实现了最先进的性能。它是基于公开可用的、合成的和人类创建的数据集训练的,主要使用英语,并遵循Llama 3.1社区许可协议。

需求人群 :

目标受众为研究人员、开发者和教育机构,他们可以利用这个模型进行自然语言处理任务,特别是在需要理解和执行复杂指令的场景中。由于模型的多任务性能,它也适合那些需要一个能够处理多种语言任务的单一模型的用户。

使用场景

研究人员使用该模型在MATH基准上测试其数学问题解答能力。

开发者将模型集成到聊天应用中,提供智能对话助手功能。

教育机构利用模型进行语言教学,增强学生的语言理解和应用能力。

产品特色

• 指令遵循:模型能够理解和执行各种任务指令。

• 多任务性能:除了聊天,还能处理数学、问答等多种任务。

• 开源数据和代码:提供完全开源的数据、代码和后训练技术指南。

• 高性能:在多个基准测试中表现出色,如MMLU、PopQA和TruthfulQA。

• 安全性考量:虽然有限的安全训练,但能够产生问题输出,尤其是当被特别提示时。

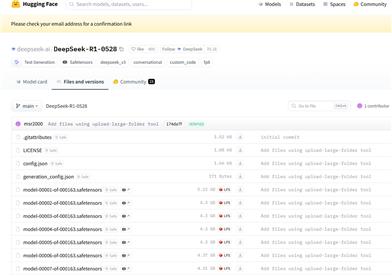

• 易于部署:可以通过HuggingFace平台轻松加载和部署。

• 社区支持:模型拥有活跃的社区,提供讨论和反馈。

使用教程

1. 访问HuggingFace平台并搜索Llama-3.1-Tulu-3-70B-SFT模型。

2. 使用提供的代码片段加载模型,例如:`from transformers import AutoModelForCausalLM; tulu_model = AutoModelForCausalLM.from_pretrained("allenai/Llama-3.1-Tulu-3-70B-SFT")`。

3. 根据需要调整模型参数,例如最大序列长度和学习率。

4. 使用模型进行任务,如文本生成或问答。

5. 评估模型性能,并根据结果进行微调。

6. 将模型部署到实际应用中,如聊天机器人或问答系统。

7. 参与社区讨论,提供反馈和改进建议。

精选AI产品推荐

智启未来,您的人工智能解决方案智库

简体中文