Mobilellm

简介 :

MobileLLM是一种针对移动设备优化的小型语言模型,专注于设计少于十亿参数的高质量LLMs,以适应移动部署的实用性。与传统观念不同,该研究强调了模型架构在小型LLMs中的重要性。通过深度和薄型架构,结合嵌入共享和分组查询注意力机制,MobileLLM在准确性上取得了显著提升,并提出了一种不增加模型大小且延迟开销小的块级权重共享方法。此外,MobileLLM模型家族在聊天基准测试中显示出与之前小型模型相比的显著改进,并在API调用任务中接近LLaMA-v2 7B的正确性,突出了小型模型在普通设备用例中的能力。

需求人群 :

MobileLLM的目标受众是那些需要在移动设备上部署高效语言模型的开发者和研究人员。由于其参数量少,适合资源受限的环境,如移动设备和边缘计算设备。此外,对于希望减少云成本和延迟的企业和开发者来说,MobileLLM提供了一个有效的解决方案。

使用场景

在智能手机上实现实时语音识别和自然语言处理

在移动应用中集成智能助手,提供个性化服务

在资源受限的物联网设备中部署语言理解功能

产品特色

• 优化的小型语言模型,参数少于十亿,适合移动设备部署

• 深度和薄型架构设计,提升模型准确性

• 嵌入共享和分组查询注意力机制,增强模型性能

• 块级权重共享方法,不增加模型大小,降低延迟

• 在聊天基准测试中表现优异,接近大型模型的正确性

• 适用于API调用任务,展现出小型模型的实用性

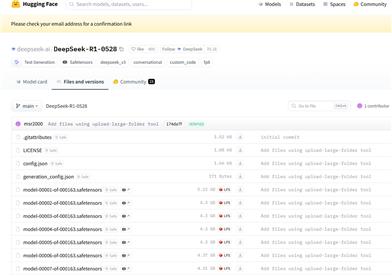

• 模型权重公开可用,便于研究和应用

使用教程

1. 访问Hugging Face平台并搜索MobileLLM模型

2. 下载适合您需求的MobileLLM模型权重

3. 根据模型文档,设置您的开发环境和依赖库

4. 将下载的模型权重加载到您的应用或服务中

5. 使用模型提供的API进行文本生成、聊天或其他语言处理任务

6. 根据需要对模型进行微调,以适应特定的用例或数据集

7. 部署模型到您的移动设备或边缘计算环境中,进行实际应用

精选AI产品推荐

智启未来,您的人工智能解决方案智库

简体中文