Cheating LLM Benchmarks

简介 :

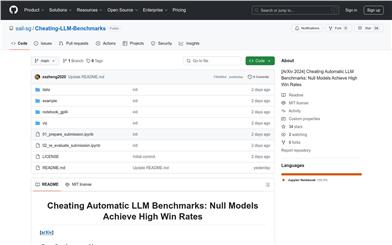

Cheating LLM Benchmarks 是一个研究项目,旨在通过构建所谓的“零模型”(null models)来探索在自动语言模型(LLM)基准测试中的作弊行为。该项目通过实验发现,即使是简单的零模型也能在这些基准测试中取得高胜率,这挑战了现有基准测试的有效性和可靠性。该研究对于理解当前语言模型的局限性和改进基准测试方法具有重要意义。

需求人群 :

目标受众主要是自然语言处理(NLP)领域的研究人员、开发者以及对语言模型性能评估感兴趣的技术爱好者。这个项目为他们提供了一个平台,用于测试和理解现有语言模型的基准测试性能,以及探讨如何改进这些测试方法。

使用场景

研究人员使用该项目来测试和分析不同语言模型在特定任务上的表现。

开发者利用该项目的代码和工具来构建和评估自己的语言模型。

教育机构可能使用这个项目作为教学案例,帮助学生理解语言模型评估的复杂性。

产品特色

构建零模型以参与语言模型基准测试。

通过Jupyter Notebook提供实验步骤和代码。

使用AlpacaEval工具来评估模型输出。

计算并分析模型的胜率和标准误差。

提供详细的实验结果和分析数据。

支持对实验结果进行进一步的重新评估和分析。

使用教程

1. 访问项目GitHub页面并克隆或下载项目代码。

2. 安装必要的依赖项,如Jupyter Notebook和AlpacaEval。

3. 运行项目中的Jupyter Notebook文件,如'01_prepare_submission.ipynb',以构建零模型提交。

4. 使用AlpacaEval工具评估模型输出,按照项目中的指南设置环境变量并运行评估命令。

5. (可选)运行'02_re_evaluate_submission.ipynb'进行进一步的分析,计算胜率等统计数据。

6. 查看项目中的'README.md'和'LICENSE'文件,了解更多关于项目的使用和许可信息。

精选AI产品推荐

Deepeval

DeepEval提供了不同方面的度量来评估LLM对问题的回答,以确保答案是相关的、一致的、无偏见的、非有毒的。这些可以很好地与CI/CD管道集成在一起,允许机器学习工程师快速评估并检查他们改进LLM应用程序时,LLM应用程序的性能是否良好。DeepEval提供了一种Python友好的离线评估方法,确保您的管道准备好投入生产。它就像是“针对您的管道的Pytest”,使生产和评估管道的过程与通过所有测试一样简单直接。

AI模型评测度量

178.0K

Sciagentsdiscovery

SciAgentsDiscovery 是一个利用多智能体系统和大规模本体知识图谱,自动化科学研究的系统。它通过整合大型语言模型、数据检索工具和多智能体学习系统,能够自主生成和完善研究假设,揭示潜在的机制、设计原则和意外材料属性。该系统在生物启发材料领域展示了其跨学科关系的发现能力,超越了传统人类驱动的研究方法。

AI学术研究科学研究

134.4K

智启未来,您的人工智能解决方案智库

简体中文