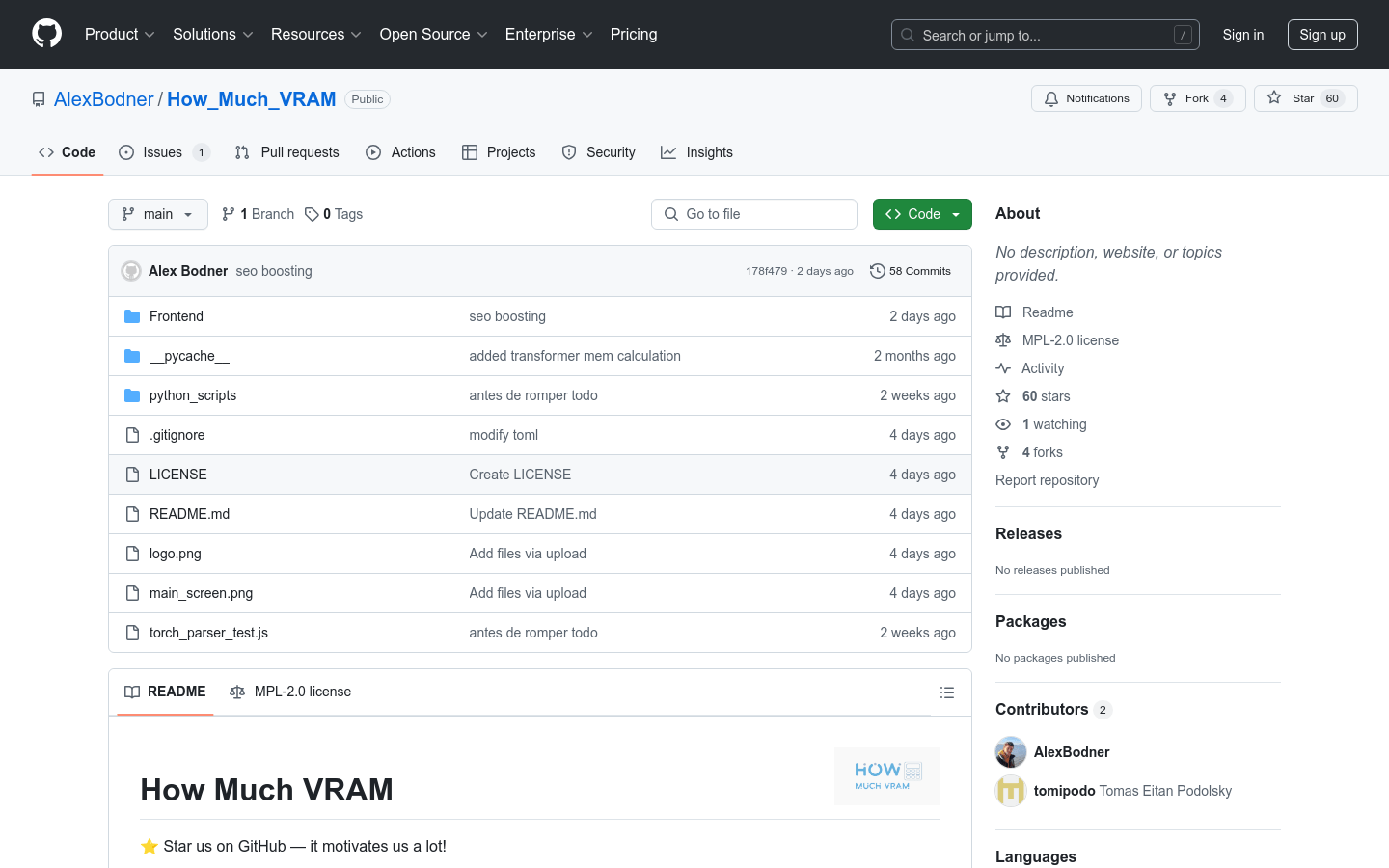

使用场景

研究人员使用该项目来估算大规模神经网络模型的显存需求。

开发者在选择合适的GPU进行模型训练前,使用该项目进行评估。

学生在课程项目中使用该工具来优化他们的硬件使用。

产品特色

估算模型训练或推理所需的显存量。

支持多种深度学习模型和框架。

提供详细的显存使用报告,帮助用户理解显存消耗。

开源项目,允许社区贡献和改进。

界面友好,易于使用。

支持本地开发和运行。

使用教程

1. 打开终端,进入项目的 'Frontend' 文件夹。

2. 运行 'npm install .' 来安装所需的依赖。

3. 执行 'npm run dev' 命令来启动本地服务器。

4. 根据提示,在浏览器中访问指定的本地主机端口,例如 'http://localhost:5173/'。

5. 使用项目提供的界面输入模型相关信息。

6. 获得显存估算结果,并根据结果进行硬件配置。

精选AI产品推荐

Openui

构建UI组件通常是一项乏味的工作。OpenUI旨在使这一过程变得有趣、快捷和灵活。这也是我们在W&B用于测试和原型化下一代工具的工具,用于在LLM的基础上构建强大的应用程序。您可以使用想象力描述UI,然后实时查看渲染效果。您可以要求进行更改,并将HTML转换为React、Svelte、Web组件等。就像是V0的开源和不太精致的版本。

AI开发助手可视化

793.8K

Opendevin

OpenDevin是一个开源项目,目标是复制、增强和创新Devin——一个能够执行复杂工程任务并与用户在软件开发项目上积极协作的自主AI软件工程师。该项目通过开源社区的力量,探索和扩展Devin的能力,识别其优势和改进空间,以指导开源代码模型的进展。

AI开发助手AI算力平台

622.1K

智启未来,您的人工智能解决方案智库

简体中文