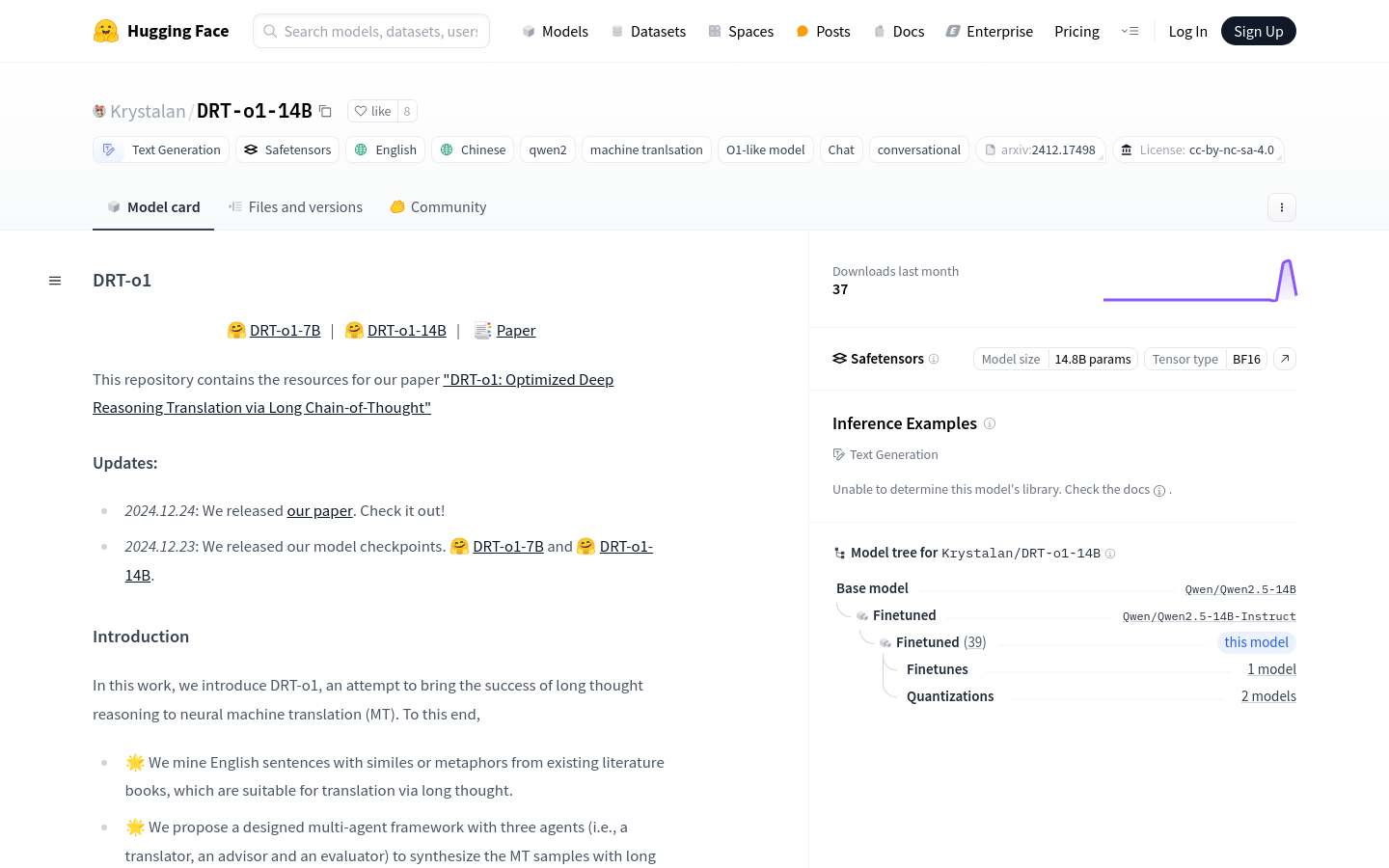

DRT O1 14B

简介 :

DRT-o1-14B是一个神经机器翻译模型,旨在通过长链推理来提升翻译的深度和准确性。该模型通过挖掘含有比喻或隐喻的英文句子,并采用多代理框架(包括翻译者、顾问和评估者)来合成长思考的机器翻译样本。DRT-o1-14B基于Qwen2.5-14B-Instruct作为主干进行训练,具有14.8B的参数量,支持BF16张量类型。该模型的重要性在于其能够处理复杂的翻译任务,尤其是在需要深入理解和推理的情况下,提供了一种新的解决方案。

需求人群 :

目标受众为需要进行复杂语言翻译的研究人员、开发者和企业,特别是那些需要深入理解和推理的翻译任务。DRT-o1-14B能够提供更深层次的翻译结果,帮助用户更好地理解和传达原文的深层含义。

使用场景

将含有隐喻的英文句子翻译成中文,以探索其深层含义。

在跨文化交流中,使用DRT-o1-14B来理解和翻译复杂的比喻表达。

在学术研究中,利用DRT-o1-14B来翻译专业文献,以获得更准确的学术信息。

产品特色

支持长链推理的神经机器翻译

挖掘含有比喻或隐喻的英文句子进行翻译

多代理框架设计,包括翻译者、顾问和评估者

基于Qwen2.5-14B-Instruct主干进行训练

支持14.8B参数量的大规模模型

支持BF16张量类型,优化计算效率

适用于需要深度理解和推理的复杂翻译任务

使用教程

1. 访问Hugging Face网站并找到DRT-o1-14B模型页面。

2. 根据页面提供的代码示例,导入必要的库和模块。

3. 设置模型名称,并从Hugging Face库中加载模型和分词器。

4. 准备翻译的英文文本,并构造系统和用户的角色消息。

5. 使用分词器将消息转换为模型输入格式。

6. 将输入传递给模型,并设置生成参数,如最大新令牌数。

7. 模型生成翻译结果后,使用分词器解码生成的令牌。

8. 输出并查看翻译结果,评估翻译的准确性和深度。

智启未来,您的人工智能解决方案智库

简体中文