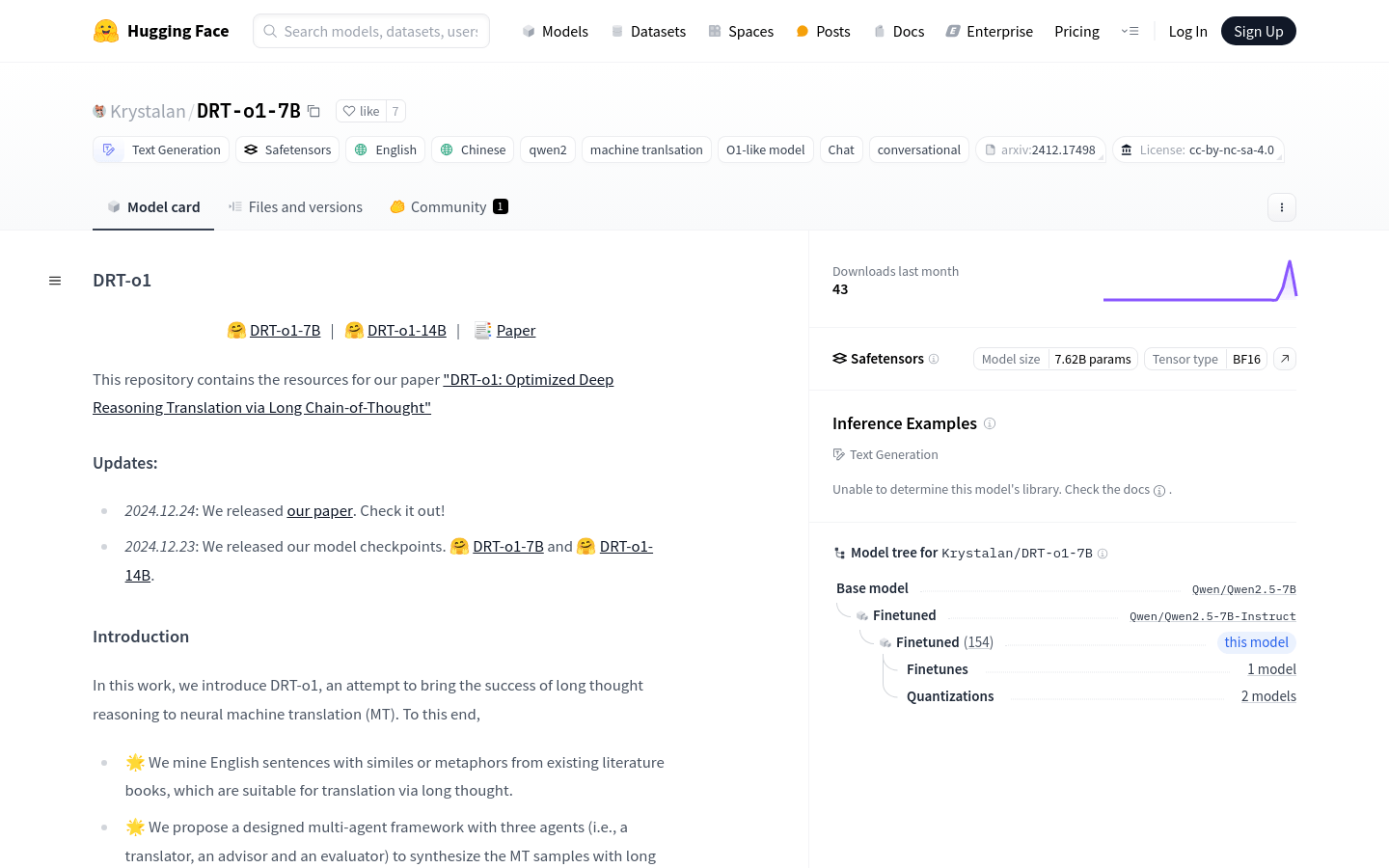

DRT O1 7B

简介 :

DRT-o1-7B是一个致力于将长思考推理成功应用于神经机器翻译(MT)的模型。该模型通过挖掘适合长思考翻译的英文句子,并提出了一个包含翻译者、顾问和评估者三个角色的多代理框架来合成MT样本。DRT-o1-7B和DRT-o1-14B使用Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct作为骨干网络进行训练。该模型的主要优点在于其能够处理复杂的语言结构和深层次的语义理解,这对于提高机器翻译的准确性和自然性至关重要。

需求人群 :

DRT-o1-7B模型的目标受众是自然语言处理领域的研究者、开发者以及机器翻译服务提供商。该模型适合他们因为它提供了一种新的、基于深度推理的方法来提高机器翻译的质量,尤其是在处理复杂语言结构时。此外,它还能够促进对长思考推理在机器翻译中应用的研究。

使用场景

案例1:使用DRT-o1-7B模型将含有隐喻的英文文学作品翻译成中文。

案例2:将DRT-o1-7B应用于跨文化交流平台,提供高质量的自动翻译服务。

案例3:在学术研究中使用DRT-o1-7B模型来分析和比较不同机器翻译模型的性能。

产品特色

• 长思考推理应用于机器翻译:通过长链思考来提升翻译质量。

• 多代理框架设计:包含翻译者、顾问和评估者三个角色,以合成MT样本。

• 基于Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct训练:使用先进的预训练模型作为基础。

• 支持英文和中文翻译:能够处理中英文之间的机器翻译任务。

• 适用于复杂语言结构:能够处理含有比喻或隐喻的复杂句子。

• 提供模型检查点:方便研究者和开发者使用和进一步研究。

• 支持Huggingface Transformers和vllm部署:易于集成和使用。

使用教程

1. 访问Huggingface官网并导航至DRT-o1-7B模型页面。

2. 根据页面提供的代码示例,导入必要的库和模块。

3. 设置模型名称为'Krystalan/DRT-o1-7B',并加载模型和分词器。

4. 准备输入文本,例如需要翻译的英文句子。

5. 使用分词器将输入文本转换为模型可接受的格式。

6. 将转换后的文本输入模型,并设置生成参数,如最大新令牌数。

7. 模型生成翻译结果后,使用分词器解码生成的令牌以获取翻译文本。

8. 输出并评估翻译结果,根据需要进行后续处理。

智启未来,您的人工智能解决方案智库

简体中文