RWKV 6 Mixture Of Experts

简介 :

Flock of Finches 37B-A11B v0.1是RWKV家族的最新成员,这是一个实验性模型,拥有11亿个活跃参数,尽管仅训练了1090亿个token,但在常见基准测试中的得分与最近发布的Finch 14B模型大致相当。该模型采用了高效的稀疏混合专家(MoE)方法,在任何给定token上仅激活一部分参数,从而在训练和推理过程中节省时间和减少计算资源的使用。尽管这种架构选择以更高的VRAM使用为代价,但从我们的角度看,能够低成本训练和运行具有更大能力模型是非常值得的。

需求人群 :

目标受众为AI研究者、数据科学家和机器学习工程师,他们需要处理大规模数据集并寻求提高模型训练和推理的效率。Flock of Finches通过MoE技术提供了一个具有更高参数总数但计算效率更高的模型,适合需要在有限资源下进行大规模模型训练和部署的专业用户。

使用场景

研究人员使用Flock of Finches模型进行自然语言处理任务,如文本分类和情感分析。

数据科学家利用该模型在有限的硬件资源下进行大规模语言模型的训练和测试。

机器学习工程师将Flock of Finches集成到他们的项目中,以提高模型的参数效率和计算性能。

产品特色

- 11亿活跃参数,37亿总参数的MoE RWKV-6架构。

- 利用MoE技术,在训练和推理中节省时间和计算资源。

- 通过hash routing实现token到专家的均匀分布,提高推理效率。

- 共享专家和新专家结合,提供动态选择的双宽度FFN。

- 使用高初始学习率训练新专家,并随着训练进展逐渐降低至原始模型的学习率。

- 支持在新专家中应用token-shift,提高模型效率。

- 在多种行业标准基准测试中表现与Finch 14B模型相当。

使用教程

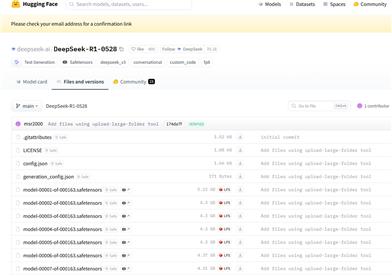

1. 访问huggingface平台,下载Flock of Finches模型和代码。

2. 根据文档说明,设置必要的硬件环境,特别是确保有足够的VRAM。

3. 使用featherless AI平台进行模型的快速测试和比较。

4. 根据项目需求,对模型进行微调和优化。

5. 在完成模型训练后,使用lm-eval-harness等工具进行基准测试。

6. 根据测试结果,调整模型参数和结构,以获得最佳性能。

7. 将训练好的模型部署到实际应用中,如聊天机器人、文本生成等。

8. 持续监控模型性能,并根据反馈进行迭代优化。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型多模态

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型图像生成

8.0M

智启未来,您的人工智能解决方案智库

简体中文