Pixtral Large Instruct 2411

简介 :

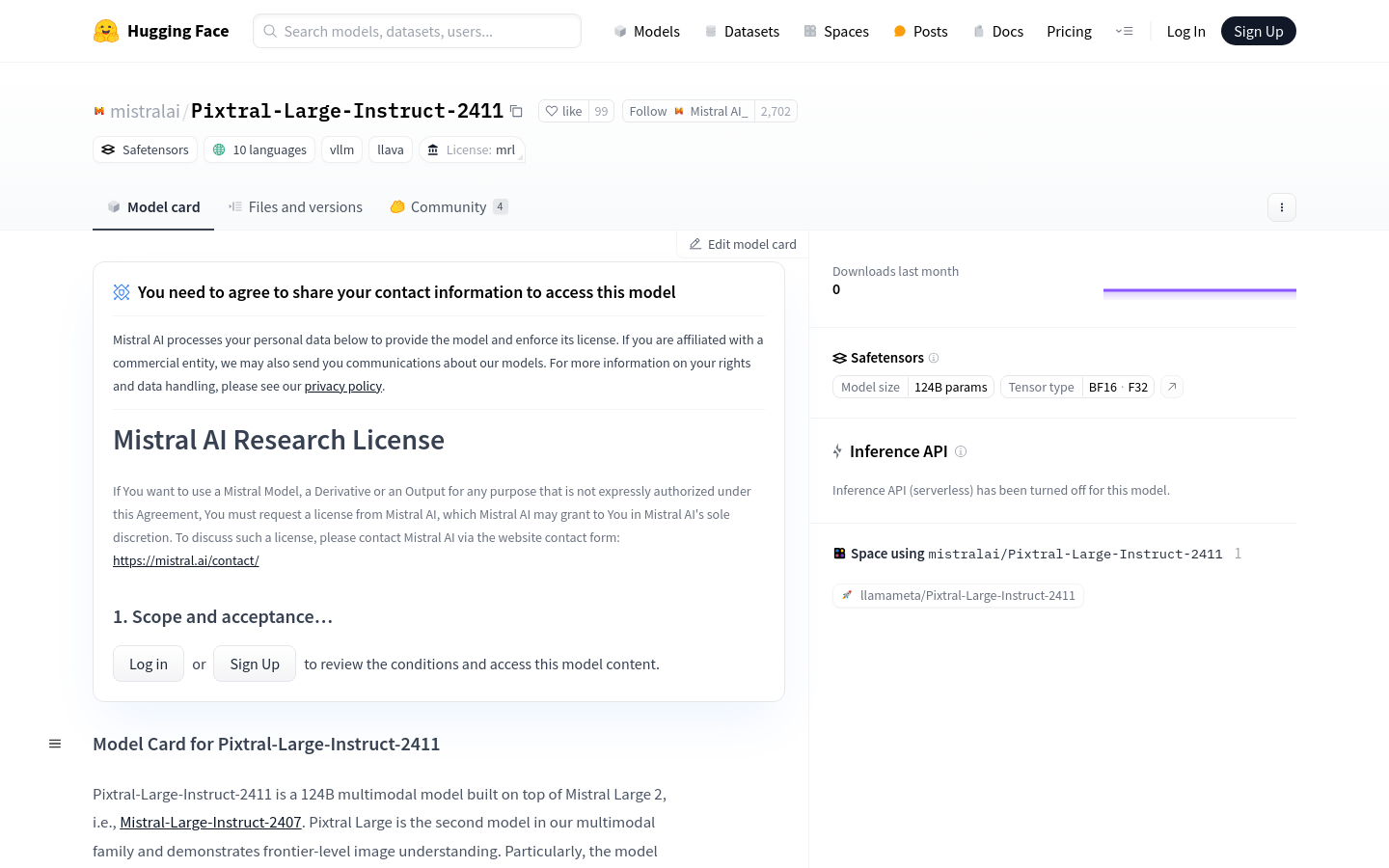

Pixtral-Large-Instruct-2411是由Mistral AI研发的124B参数的大型多模态模型,基于Mistral Large 2构建,展现出前沿级别的图像理解能力。该模型不仅能够理解文档、图表和自然图像,同时保持了Mistral Large 2在文本理解方面的领先地位。它在MathVista、DocVQA、VQAv2等数据集上达到了最先进的性能,是科研和商业应用的强大工具。

需求人群 :

目标受众为研究人员、开发者和企业,他们需要一个能够理解和处理大量图像与文本数据的高性能AI模型。Pixtral-Large-Instruct-2411以其强大的多模态处理能力和前沿的研究成果,非常适合需要进行复杂数据分析和模式识别的专业用户。

使用场景

在DocVQA数据集上,Pixtral-Large-Instruct-2411能够准确理解文档内容并回答问题。

在MathVista上,模型能够解决复杂的数学问题,展现了其在数学理解方面的能力。

在VQAv2数据集上,模型能够识别图像中的视觉元素,并回答相关问题。

产品特色

前沿级多模态性能:在多个图像理解数据集上达到领先成绩。

扩展Mistral Large 2:在不牺牲文本性能的前提下,增加了对图像的理解能力。

123B多模态解码器和1B参数视觉编码器:提供了强大的图像和文本处理能力。

128K上下文窗口:能够适应至少30张高分辨率图像。

系统提示处理:强化了对系统提示的支持,以实现最佳效果。

基础指令模板(V7):提供了标准化的模板,以指导模型的响应。

研究目的使用:模型和衍生产品仅限于研究目的使用。

使用教程

1. 安装vLLM库:确保安装了vLLM >= v0.6.4.post1和mistral_common >= 1.5.0。

2. 启动服务器:使用vLLM serve命令启动Pixtral-Large-Instruct-2411模型的服务。

3. 配置系统提示:根据需要,加载并配置SYSTEM_PROMPT.txt文件,以指导模型的行为。

4. 构建请求:构建包含系统提示和用户消息的请求数据,包括文本和图像URL。

5. 发送请求:使用HTTP POST请求将数据发送到服务器,并接收模型的响应。

6. 处理响应:解析模型返回的响应,提取有用的信息。

7. 离线使用:如果需要,也可以在没有服务器的情况下,使用vLLM库直接在本地运行模型。

精选AI产品推荐

中文精选

抖音即创

即创工作台是一个一站式的智能创意生产与管理平台。它集成了视频创作、图文创作、直播创作等多种创意工具,可以通过AI的力量大大提高创作效率。主要功能和优势包括:1)视频创作:内置多种AI视频创作工具,支持智能编剧、数字人物、一键成片等,可快速生成高质量视频内容;2)图文创作:提供智能图文和商品图片生成工具,可快速制作微信文章、产品详情等图文内容;3)直播创作:支持AI直播背景、直播文案等创作工具,可轻松制作抖音、快手等直播内容。定位为新创和创意从业者的创意助手,以合理价格提供创意生产全流程服务。

AI设计工具内容生产

106.7M

国外精选

Pika

Pika是一个视频制作平台,用户可以上传自己的创意想法,Pika会自动生成相关的视频。主要功能有:支持多种创意想法转视频,视频效果专业,操作简单易用。平台采用免费试用模式,定位面向创意者和视频爱好者。

视频生成人工智能

18.7M

智启未来,您的人工智能解决方案智库

简体中文